Tudo sobre Inteligência Artificial

Uma nova pesquisa publicada na revista Nature revela que grandes modelos de linguagem (LLMs) que vêm ficando mais poderosos acabam fazendo as IAs ‘mentirem’ com mais frequência. De certa forma, as inteligências artificiais estariam se tornando menos confiáveis conforme se tornam mais “experts” em tudo.

O estudo analisou modelos como o GPT da OpenAI, o LLaMA da Meta e o BLOOM do grupo BigScience. Os testes se baseiam em tópicos variados, de matemática a geografia, e em tarefas como listar informações em uma ordem específica.

Leia também:

Os modelos maiores e mais poderosos deram as respostas mais precisas, mas vacilaram em perguntas mais difíceis. Em suma, quanto maiores os modelos de IA ficavam – em termos de parâmetros, dados de treinamento e outros fatores – maior a porcentagem de respostas erradas que eles deram.

José Hernández-Orallo, pesquisador do Instituto Valenciano de Pesquisa de Inteligência Artificial, explicou que esses modelos estão respondendo a quase tudo. Isso resulta em mais respostas corretas, mas também em mais respostas incorretas.

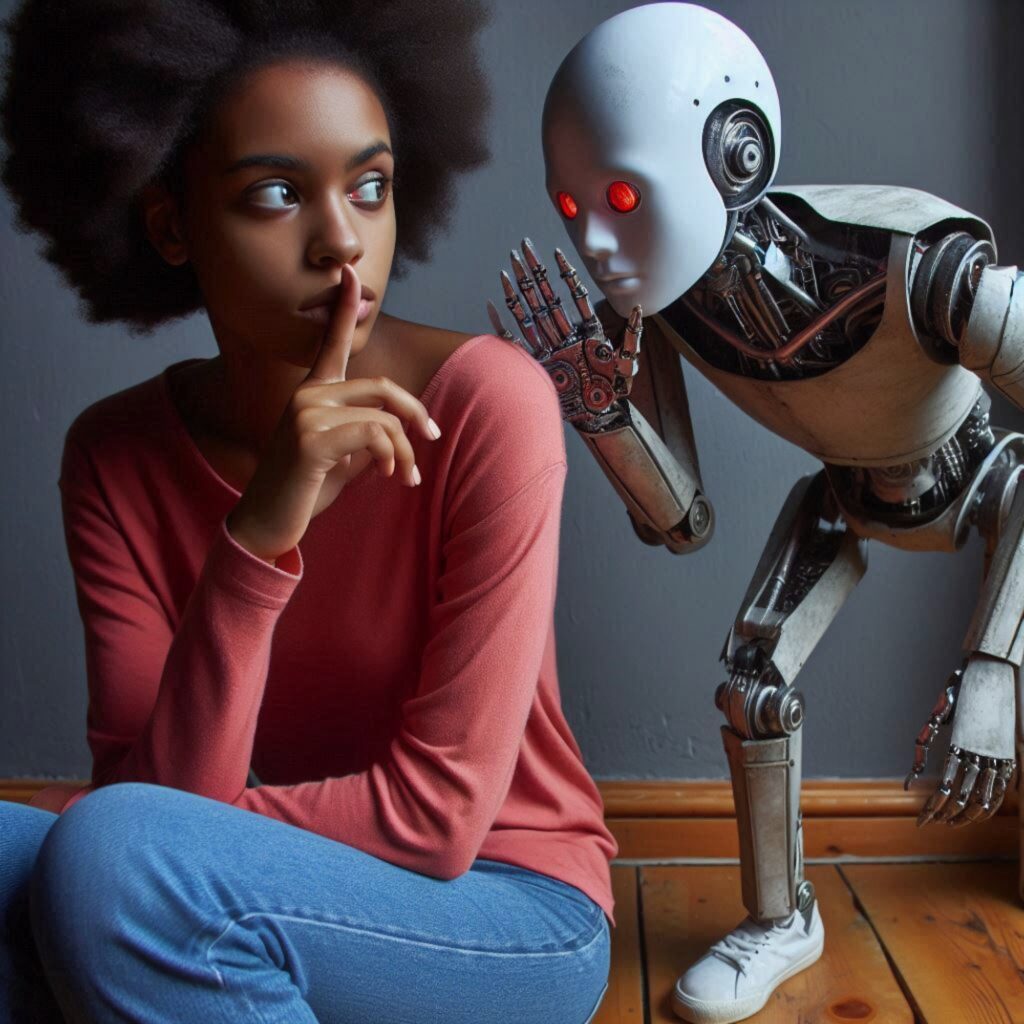

É difícil para humanos saber se IA está mentindo

Os pesquisadores sugerem que uma solução para as IAs evitarem ‘mentir’ seria programar os LLMs para serem menos ansiosos em responder a tudo, admitindo quando não sabem a resposta. No entanto, essa abordagem pode não ser do interesse das empresas de inteligência artificial, que buscam impressionar o público com a sofisticação das tecnologias.

A pesquisa levanta preocupações sobre como os humanos percebem as respostas da IA. Quando solicitados a julgar a precisão das respostas dos chatbots, um grupo selecionado de indivíduos errou entre 10% e 40% das vezes.

Via Futurism