A OpenAI está tomando medidas enérgicas contra usuários que tentam entender o processo de “raciocínio” por trás de seus últimos modelos de IA, o1-preview e o1-mini. Embora a empresa afirme que esses modelos são capazes de resolver problemas passo a passo, ela esconde deliberadamente o raciocínio bruto dos usuários, mostrando apenas uma versão filtrada criada por uma segunda IA.

Essa ocultação de informações despertou a curiosidade de hackers e pesquisadores de segurança, que estão utilizando técnicas como jailbreaking e prompt injection para tentar revelar o raciocínio bruto do o1. No entanto, a OpenAI está monitorando essas tentativas através da interface do ChatGPT e punindo os usuários, mesmo aqueles com intenções benignas.

“Lista de banidos” inclui pesquisadores de segurança

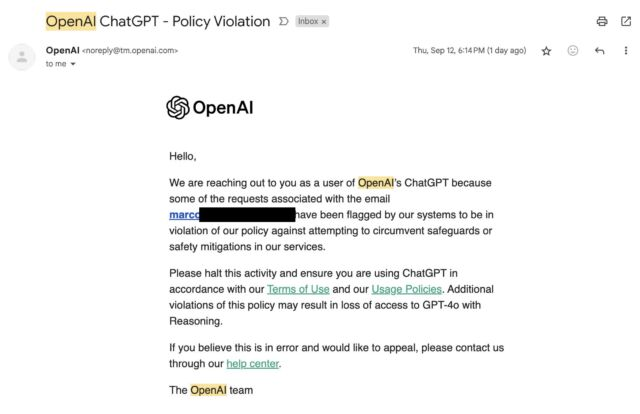

Usuários relataram ter recebido e-mails de aviso da OpenAI após usarem termos como “raciocínio” ou “rastreamento de raciocínio” em conversas com o o1. O email adverte que tais solicitações violam as políticas da empresa contra a contornação de salvaguardas e medidas de segurança, ameaçando os usuários com a perda de acesso aos modelos.

Marco Figueroa, gerente de programas de recompensas por bugs de IA da Mozilla, foi um dos primeiros a relatar publicamente o recebimento do aviso da OpenAI. Ele expressou frustração com a situação, afirmando que a censura da empresa atrapalha sua capacidade de realizar pesquisas de segurança positivas no modelo.

“Estava muito focado no #AIRedTeaming para perceber que recebi este e-mail da @OpenAI ontem, depois de todos os meus jailbreaks. Agora estou na lista de banidos!!!”, escreveu ele na rede social X, banida no Brasil.

Transparência x “vantagem competitiva”

Em um artigo intitulado “Aprendendo a Raciocinar com LLMs”, a OpenAI justifica a ocultação do raciocínio bruto, argumentando que isso permite monitorar o “pensamento” do modelo e identificar potenciais manipulações. No entanto, a empresa também admite que essa prática visa proteger seus interesses comerciais, incluindo a manutenção de uma “vantagem competitiva”.

Simon Willison, pesquisador independente de IA, criticou a decisão da OpenAI, afirmando que a empresa está priorizando o sigilo em detrimento da transparência e da capacidade da comunidade de entender e aprimorar esses modelos.

“Não estou nem um pouco feliz com essa decisão política”, escreveu Willison. “Como alguém que desenvolve contra LLMs, a interpretabilidade e a transparência são tudo para mim – a ideia de que posso executar um prompt complexo e ter os principais detalhes de como esse prompt foi avaliado ocultos parece um grande passo para trás.”