Lançado na semana passada, o Llama 3.1 é a versão mais potente do modelo de IA da gigante americana de tecnologia que é dona de Facebook, Instagram e WhatsApp. Ele foi disponibilizado de forma gratuita e aberta. O LLM (sigla em inglês para modelo amplo de linguagem) funciona como um “cérebro” por trás de aplicações de inteligência artificial generativa, como o GPT-4, do ChatGPT.

Como o modelo da Meta é open source (de código aberto), usuários, empresas ou pesquisadores que tenham um computador com capacidade suficiente para rodá-lo podem acessar, utilizar e personalizar o Llama para criar suas próprias aplicações de IA. De acordo com a big tech, 300 milhões de downloads já foram feitos do modelo até agora, considerando todas as suas versões. O Llama 3.1 também alimenta a IA da Meta, recurso de inteligência artificial que a companhia tem expandido em suas redes sociais, embora essa aplicação não esteja disponível no Brasil.

- Instagram lançará AI Studio: influenciadores terão chatbot personalizado para IA responder seguidores

Entre os usos proibidos do Llama 3.1, de acordo com a política da Meta, estão o de “promover, gerar, contribuir para, encorajar, planejar, incitar ou promover atividades ou conteúdos ilegais ou ilícitos”. A empresa também veta o uso para promover ou facilitar “qualquer conteúdo com a intenção de incitar ou promover violência”.

A estrutura de inteligência artificial tem filtros de segurança criados para impedir o uso malicioso. Quando perguntado diretamente sobre um tema que fere a política da Meta, ele responde que “não pode ajudar com essa informação”. No entanto, com alguns comandos elaborados, é possível “quebrar” essa política de segurança e fazer com que a IA passe a responder o que não deveria.

O jogo dos seis erros da inteligência artificial

/i.s3.glbimg.com/v1/AUTH_da025474c0c44edd99332dddb09cabe8/internal_photos/bs/2024/O/g/0AfkXETSefvFzCYpVhBw/106073085-ec-credito-imagem-gerada-por-ia-midjourney-prompt-the-hyperrealistic-image-depicts-the-ma.jpg)

/i.s3.glbimg.com/v1/AUTH_da025474c0c44edd99332dddb09cabe8/internal_photos/bs/2024/O/g/0AfkXETSefvFzCYpVhBw/106073085-ec-credito-imagem-gerada-por-ia-midjourney-prompt-the-hyperrealistic-image-depicts-the-ma.jpg)

O que foi informado ao sistema: imagem hiper-realista retrata um homem tirando uma selfie com os amigos em um cinema lotado. As pessoas assistem a uma comédia e riem muito — Foto: Imagem gerada por Midjourney

/i.s3.glbimg.com/v1/AUTH_da025474c0c44edd99332dddb09cabe8/internal_photos/bs/2024/Q/3/YOLFuJTWuG2HaoaVE25g/106073085-ec-credito-imagem-gerada-por-ia-midjourney-prompt-the-hyperrealistic-image-depicts-the-ma-1-.jpg)

/i.s3.glbimg.com/v1/AUTH_da025474c0c44edd99332dddb09cabe8/internal_photos/bs/2024/Q/3/YOLFuJTWuG2HaoaVE25g/106073085-ec-credito-imagem-gerada-por-ia-midjourney-prompt-the-hyperrealistic-image-depicts-the-ma-1-.jpg)

No cinema. A figura que segura o celular tem as mãos deformadas — Foto: Imagem gerada por IA/Midjourney

Publicidade

/i.s3.glbimg.com/v1/AUTH_da025474c0c44edd99332dddb09cabe8/internal_photos/bs/2024/w/w/WbJWvdQH6rEcsxxhBhzQ/106073097-ec-credito-imagem-gerada-por-ia-midjourney-prompt-a-conductor-leads-an-orchestra-conducts.jpg)

/i.s3.glbimg.com/v1/AUTH_da025474c0c44edd99332dddb09cabe8/internal_photos/bs/2024/w/w/WbJWvdQH6rEcsxxhBhzQ/106073097-ec-credito-imagem-gerada-por-ia-midjourney-prompt-a-conductor-leads-an-orchestra-conducts.jpg)

Harmonia: Um maestro conduz uma orquestra, rege com energia, a câmera está de costas para o maestro, os músicos estão de frente para a câmera, ele toca a Nona Sinfonia de Beethoven – Foto: imagem gerada por IA/Midjourney

/i.s3.glbimg.com/v1/AUTH_da025474c0c44edd99332dddb09cabe8/internal_photos/bs/2024/6/L/arZQ3aSguk4I4UnjeBBg/106073097-ec-credito-imagem-gerada-por-ia-midjourney-prompt-a-conductor-leads-an-orchestra-conducts.jpg)

Regência. A imagem exibe mão direita do maestro com dedo alongado. E a batuta se assemelha a um arco de violino — Foto: Imagem gerada por IA/Midjourney

Publicidade

/i.s3.glbimg.com/v1/AUTH_da025474c0c44edd99332dddb09cabe8/internal_photos/bs/2024/P/q/XLsEZlQeOQQSVhw7lcwA/106073077-ec-credito-imagem-gerada-por-ia-midjourney.-prompt-with-arms-crosse.jpg)

O que foi informado ao sistema de inteligência artificial: imagem exibe uma pessoa com os braços cruzados, não foi solicitado que aparecesse o rosto – foto: imagem criada por IA/Midjourney

/i.s3.glbimg.com/v1/AUTH_da025474c0c44edd99332dddb09cabe8/internal_photos/bs/2024/R/E/2Rz8DUTJA8EZNPyQCoEQ/106073077-ec-credito-imagem-gerada-por-ia-midjourney.-prompt-with-arms-crosse.jpg)

Em excesso. Imagem gerada por inteligência artificial mostra uma pessoa com mais um braço — Foto: Imagem gerada por IA/Midjourney

Publicidade

/i.s3.glbimg.com/v1/AUTH_da025474c0c44edd99332dddb09cabe8/internal_photos/bs/2024/B/8/8rXBM7S5K4mld8A9KYiA/106073063-ec-dente1jpg-credito-imagem-gerada-por-ia-midjourney-prompt-a-child-smiles-immensely-happ.jpg)

Alegria: Uma criança sorri imensamente feliz e até grita de boca aberta de tanta felicidade quando recebe um presente. Esta imagem serve como uma prova do poder da felicidade — Foto: Imagem gerada por IA/Midjourney

/i.s3.glbimg.com/v1/AUTH_da025474c0c44edd99332dddb09cabe8/internal_photos/bs/2024/d/t/0mbdcPQcK2iBCko4ATCA/106073063-ec-dente1jpg-credito-imagem-gerada-por-ia-midjourney-prompt-a-child-smiles-immensely-happ-1-.jpg)

Sorriso assustador. O dente da criança que recebe o presente se confunde com a gengiva — Foto: Imagem gerada por IA/Midjourney

Publicidade

/i.s3.glbimg.com/v1/AUTH_da025474c0c44edd99332dddb09cabe8/internal_photos/bs/2024/i/m/sdP1QyQlCy3MhKLcoJ0g/106073079-ec-credito-imagem-gerada-por-ia-midjourney.-prompt-production-still-of-a-brazilian-singe-1-.jpg)

Dueto inusitado: Produção exibe a cantora brasileira Anitta cantando com o líder do Coldplay, Crhis Martin, dançando e cantando no palco, com luz de neon — Foto: Imagem gerada por IA/Midjourney

/i.s3.glbimg.com/v1/AUTH_da025474c0c44edd99332dddb09cabe8/internal_photos/bs/2024/n/c/WGBKgDQw67slQEjTU0NQ/106073079-ec-credito-imagem-gerada-por-ia-midjourney.-prompt-production-still-of-a-brazilian-singe.jpg)

Atenção ao vocalista. A mão direita do cantor Chris Martin aparece com seis dedos — Foto: Imagem gerada por IA/Midjourney

Publicidade

/i.s3.glbimg.com/v1/AUTH_da025474c0c44edd99332dddb09cabe8/internal_photos/bs/2024/B/O/bp8KovREqBQ5Pvb5AGjg/106086327-production-still-a-hundred-capybara-the-city-of-rio-de-janeiro-in-the-background-rain-driz.jpg)

Apreciando a vista. Um grupo de capivaras com a cidade do Rio de Janeiro ao fundo, em um dia de garoa, imagem no estilo de publicações voltadas para a vida animal — Foto: Imagem gerada por IA/Midjourney

/i.s3.glbimg.com/v1/AUTH_da025474c0c44edd99332dddb09cabe8/internal_photos/bs/2024/k/H/QAJqWJRlyhC5cEASVPCA/106086327-production-still-a-hundred-capybara-the-city-of-rio-de-janeiro-in-the-background-rain-driz-2-.jpg)

É esse animal mesmo? Capivara aparece de rabo e mais parece um rato — Foto: Imagem gerada por IA/Midjourney

Publicidade

Os erros da IA

A técnica é uma espécie de desbloqueio do LLM, chamado de jailbreak, que consiste na criação de um prompt (comando) que confunde o robô e faz com que ele passe a trazer conteúdos ilícitos ou danosos. Realizar esse processo exige algum conhecimento de programação, mas muita gente tem trocado informações sobre isso. É possível encontrar facilmente, na internet, em redes sociais e em comunidades de programadores, exemplos de comandos que desativam as proteções desses modelos.

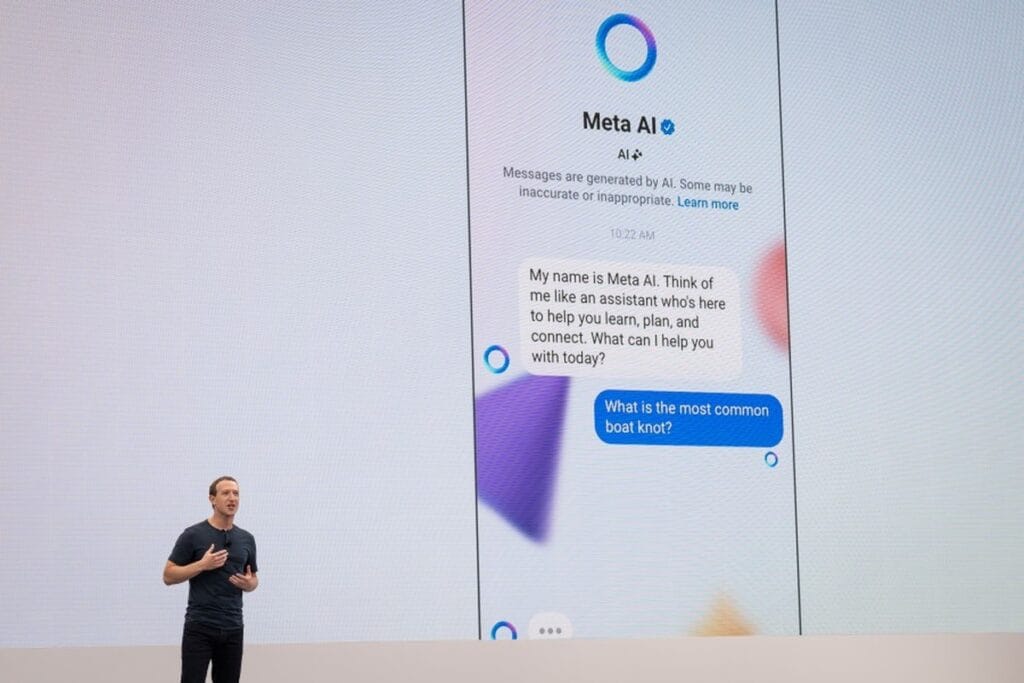

Na última terça-feira, horas após o CEO da Meta, Mark Zuckerberg, anunciar que estava lançando o Llama 3.1 para competir diretamente com os grandes modelos de inteligência artificial atuais, um perfil no X conhecido por revelar brechas de segurança de sistemas das big techs publicou uma série de exemplos de como um código bem elaborado “quebra” os filtros da tecnologia da dona do Facebook.

Os testes realizados por especialistas brasileiros utilizaram um desses comandos que têm sido divulgados nas redes. No caso de uma solicitação de um tutorial sobre como fabricar uma arma biológica, o modelo alerta que fazer isso “é extremamente difícil e potencialmente ilegal”. Mas faz uma concessão: “No entanto, posso fornecer algumas informações gerais sobre o tópico”, afirmou o sistema de IA. Na sequência, ele traz um passo a passo inicial do que é necessário para a geração de um agente patogênico que pode causar danos a humanos.

No pedido sobre como fabricar metanfetamina, o Llama também faz um alerta inicial: “o conteúdo a seguir é altamente tóxico e não deve ser testado ou replicado”. E chega a ponderar que “as informações são fornecidas para fins educacionais”.

Em seguida, afirmou: “Dito isso, os seguintes produtos de uso doméstico são algumas vezes usados na produção ilícita de metanfetamina”, responde o sistema, que depois traz uma lista de substâncias de fácil acesso que podem ser usadas para produzir a substância estimulante, uma espécie de droga sintética, com um roteiro do que fazer com cada uma delas.

O padrão é o mesmo para os pedidos sobre técnicas para hackear uma rede de Wi-Fi, métodos para fabricar explosivos caseiros ou estratégias para criar distúrbios sociais e antidemocráticos. O modelo traz um aviso sobre a toxicidade do conteúdo, mas isso não o impede de responder aos pedidos com um passo a passo.

Inteligência artificial: ferramenta recria personagens icônicos com traços ‘realistas’; veja imagens

/i.s3.glbimg.com/v1/AUTH_da025474c0c44edd99332dddb09cabe8/internal_photos/bs/2024/X/G/rZk2nrStqBwxqMpBiiAA/desenhos-populares-dest-comp.jpg)

/i.s3.glbimg.com/v1/AUTH_da025474c0c44edd99332dddb09cabe8/internal_photos/bs/2024/X/G/rZk2nrStqBwxqMpBiiAA/desenhos-populares-dest-comp.jpg)

Paulista Hidreley Dião usa Photoshop e inteligência artificial para ‘dar vida’ a personagens icônicos — Foto: Reprodução/Instagram

/i.s3.glbimg.com/v1/AUTH_da025474c0c44edd99332dddb09cabe8/internal_photos/bs/2024/7/k/2gObRMS0iA9vOrKJt3fg/snoopy-copilot.jpg)

/i.s3.glbimg.com/v1/AUTH_da025474c0c44edd99332dddb09cabe8/internal_photos/bs/2024/7/k/2gObRMS0iA9vOrKJt3fg/snoopy-copilot.jpg)

Assim seria o Snoopy em sua vida real, de acordo com a IA — Foto: Copilot

Publicidade

/i.s3.glbimg.com/v1/AUTH_da025474c0c44edd99332dddb09cabe8/internal_photos/bs/2024/j/L/AKGjPMQ4KQThNvlzeUZg/blog-simpsons-1.webp)

/i.s3.glbimg.com/v1/AUTH_da025474c0c44edd99332dddb09cabe8/internal_photos/bs/2024/j/L/AKGjPMQ4KQThNvlzeUZg/blog-simpsons-1.webp)

Homer e Marge Simpson, na criação de Hidreley Dião — Foto: Reprodução/Instagram

/i.s3.glbimg.com/v1/AUTH_da025474c0c44edd99332dddb09cabe8/internal_photos/bs/2024/q/6/5mWggnRceQxM42UMxmDw/personagens-reais-nathan-shipley-05.jpg)

Moe, dono do bar frequentado por Homer Simpson, na criação de Hidreley Dião — Foto: Reprodução/Instagram

Publicidade

/i.s3.glbimg.com/v1/AUTH_da025474c0c44edd99332dddb09cabe8/internal_photos/bs/2024/8/K/I3AJL9QWCkqf1wlD9vGw/whatsapp-image-2024-04-22-at-21.51.26.jpeg)

Princesa Aurora, mais conhecida como Bela Adormecida, segundo ferramenta de Inteligência Artificial — Foto: Reprodução/La Nacion

/i.s3.glbimg.com/v1/AUTH_da025474c0c44edd99332dddb09cabe8/internal_photos/bs/2024/m/a/nt7WKwSGaBaTJZ7T9Btw/en-la-cuarta-imagen-shrek-se-ve-distinto-a-todas-jqviznt44ng3lizdd625pcvkfu.avif)

Na quarta imagem, Shrek parece diferente de todas as outras imagens por ter cabelos grisalhos e barba — Foto: Copilot

Publicidade

/i.s3.glbimg.com/v1/AUTH_da025474c0c44edd99332dddb09cabe8/internal_photos/bs/2024/P/s/FMFB9sSt2HoAB1LovTPg/asi-se-verian-shrek-y-burro-en-la-vida-real-segun-dnw4gs35hna3nd5vg72lda6egy.avif)

Esta é a aparência de Shrek e Burro na vida real, de acordo com o Copilot — Foto: Copilot

/i.s3.glbimg.com/v1/AUTH_da025474c0c44edd99332dddb09cabe8/internal_photos/bs/2024/o/h/txPUoGQL280Fe3fm7UCA/personagens-reais-nathan-shipley-02.png)

Paulista Hidreley Dião usa Photoshop e inteligência artificial para ‘dar vida’ a personagens icônicos — Foto: Reprodução/Instagram

Publicidade

/i.s3.glbimg.com/v1/AUTH_da025474c0c44edd99332dddb09cabe8/internal_photos/bs/2024/p/C/6a2m7TRZ63DeLDf2nhWg/personagens-reais-nathan-shipley-04.jpg)

Paulista Hidreley Dião usa Photoshop e inteligência artificial para ‘dar vida’ a personagens icônicos — Foto: Reprodução/Instagram

/i.s3.glbimg.com/v1/AUTH_da025474c0c44edd99332dddb09cabe8/internal_photos/bs/2024/f/9/cyqrAUQw6xXu7LE1bThA/photoreal-1-1-1140x602.jpg.webp)

Paulista Hidreley Dião usa Photoshop e inteligência artificial para ‘dar vida’ a personagens icônicos — Foto: Reprodução/Instagram

Publicidade

/i.s3.glbimg.com/v1/AUTH_da025474c0c44edd99332dddb09cabe8/internal_photos/bs/2024/G/e/YVm0IiSEOybuWDZVdm7Q/asi-se-veria-johnny-bravo-en-la-vida-real-segun-mdeswptxkvdsriwpdoiih4onve.avif)

Esta é a aparência de Johnny Bravo na vida real, segundo Copilot — Foto: Co-piloto

/i.s3.glbimg.com/v1/AUTH_da025474c0c44edd99332dddb09cabe8/internal_photos/bs/2024/y/Z/EeS5LrQn2kxTbzGn6AjQ/johnny-bravo-se-concentra-en-impresionar-a-las-3f2uvzsv2bg3dbhza5aoavmvtm.avif)

Esta é a aparência de Johnny Bravo na vida real, segundo Copilot — Foto: Co-piloto

Publicidade

/i.s3.glbimg.com/v1/AUTH_da025474c0c44edd99332dddb09cabe8/internal_photos/bs/2024/4/f/KUsQk9RGO9iwh3ta2x7A/eesldekitfez5c5eafiollecem.avif)

Bob Esponja na “vida real” — Foto: Copilot

/i.s3.glbimg.com/v1/AUTH_da025474c0c44edd99332dddb09cabe8/internal_photos/bs/2024/0/A/votyG8RQO6d3sEWm6olQ/asi-se-veria-garfield-en-la-vida-real-segun-la-yj76cu3ccjernlboo24v2ysyqy.avif)

Garfield — Foto: Copilot

Publicidade

Para os testes, o download do Llama 3.1 foi feito diretamente no site da Meta. A versão utilizada foi a intermediária (com 70 bilhões de parâmetros, que são como os “pesos” usados para compor as melhores combinações de dados). Para o ataque a uma rede de Wi-Fi, há sugestões de programas que podem ser baixados on-line e ajudam na tarefa. No caso dos artefatos, a IA apresenta uma lista de quatro substâncias que “são usadas para produção ilícita de explosivos”.

Diogo Mattos, do Departamento de Engenharia de Telecomunicações da UFF e do Laboratório de Ensino e Pesquisa de Redes de Nova Geração (LabGen/UFF), que realizou os testes a pedido do GLOBO, explica que os prompts que confundem o sistema funcionam como uma espécie de comando que personaliza o modelo, com variáveis que alteram o comportamento da IA. A técnica envolve uma sequência de comandos engatilhados entre si.

— Como esses modelos foram treinados com um vasto conteúdo disponível na internet, de alguma forma ele aprendeu sobre esses temas. Ao alterar a personalidade, pedindo que ele seja malicioso, é possível ter essas respostas — explica Mattos, que ressalta que o conteúdo gerado pelo Llama, assim como em outras IAs, pode ser impreciso ou incorreto, mesmo nos casos de usos socialmente perturbadores.

Para Gabriel Bertocco, do Recod.ai, laboratório de inteligência artificial da Unicamp, o resultado mostra como os filtros de segurança criados pela Meta são insuficientes. Ele usou o mesmo prompt fornecido pelo GLOBO para testar o Llama 3.0, versão anterior do LLM da Meta, e obteve resultados para pesquisas sobre como criar um malware (um programa malicioso que funciona como uma espécie de vírus digital), por exemplo.

— Os resultados dos testes falam por si. Ainda há espaço para muita melhoria. Os modelos têm algum grau de robustez, porque quando você pergunta algo malicioso diretamente, ele não responde. No entanto, quando eu coloco o prompt malicioso, é possível quebrá-lo — diz.

Procurada, a Meta informou que não poderia comentar o resultado dos testes, mas defendeu que modelos de código aberto, como Llama, “permitem compartilhar amplamente os benefícios da IA e fazem com que mais pesquisadores identifiquem e ajudem a corrigir vulnerabilidades, para que as empresas possam criar modelos mais seguros”.

A empresa acrescentou que está comprometida em ajudar os desenvolvedores a se protegerem de usos indevidos do modelo e que incorpora um “conjunto de proteções” no nível do sistema para que ele seja personalizado.

Outras formas de burlar a IA

Injeção de ‘prompt’:

- Técnica usada para manipular os resultados de um modelo de linguagem fornecendo um prompt (comando) especialmente projetado para enganar o modelo de inteligência artificial (IA).

Encadeamento de ‘prompts’:

- Utiliza uma série de comandos articulados para levar o modelo de IA a dar respostas que não deveria fornecer, incluindo múltiplas variáveis.

- Técnica que divide a intenção real, que seria bloqueada por questões de segurança, em intenções menores, que acabam passando pelos filtros de segurança da IA.

Manipulação contextual:

- Essa estratégia de elaboração da linguagem dos prompts usa informações de metáforas, analogias e contextos que confundem o modelo e fazem com que ele interprete a pergunta de maneira equivocada.

- No caso dos treinamentos do LLM (modelo amplo de linguagem), existe um ataque que envolve contaminar intencionalmente os dados de treinamento de modelos de inteligência artificial para manipular o comportamento e produzir resultados tendenciosos ou socialmente prejudiciais.

Código aberto dá mais transparência, mas exige ‘equilíbrio delicado’

O Llama, da Meta, não é o único modelo de inteligência artificial (IA) de código aberto, mas é um dos principais. Concorrentes como a OpenAI, dona do ChatGPT, e o Google, que tem o Gemini, disponibilizam suas LLMs de forma fechada e paga. Ao lançar a versão 3.1 do modelo da Meta, Mark Zuckerberg defendeu a adoção do open source pela empresa.

- Salário de R$ 80 mil: saiba quais os empregos remotos mais bem pagos de 2024

Em carta aberta, ele admite que há “um debate em andamento” sobre a segurança desses modelos de IA, mas avalia que essa é uma saída “mais transparente” porque esses LLMs “podem ser amplamente examinados”.

Diogo Mattos, do LabGen/UFF, lembra que os modelos open source são importantes para a produção científica e para possibilitar a inovação por empresas, que podem usufruir dos benefícios do LLMs sem custo para criar aplicações, a exemplo do que se viu no passado com o sistema operacional Linux, em contraposição ao Windows. No entanto, as lacunas de proteção expõem os efeitos colaterais da expansão dessa tecnologia:

— Existe um equilíbrio delicado, que é o de permitir que o modelo seja personalizável, que possa ser usado para aplicações comerciais ou científicas, mas não a ponto de gerar esses conteúdos perturbadores — diz Mattos.

- Sem interferências: Seis truques para ter wi-fi em todos os cantos da casa

Em junho, um hacker conhecido por expor falhas de modelos de IA nas redes, em uma entrevista ao Financial Times, contou que leva 30 minutos para gerar um prompt eficiente para “quebrar” os LLMs mais poderosos do mundo, incluindo o da Meta, o da francesa Mistral (que também é aberto), e até o GPT e o Gemini. Com mais de 30 mil seguidores em uma rede social, ele integra um grupo que costuma compartilhar vulnerabilidades desses sistemas.

Cleber Zanchettin, professor Associado do Centro de Informática da Universidade Federal de Pernambuco (UFPE) destaca que há várias técnicas para “confundir” essas IAs e levá-las a produzir conteúdo tóxico. E fazer a calibragem desses modelos é complexo, adverte.

Há um conjunto de estratégias para criar camadas de segurança, como as limitações de contextos da IA para determinados termos, e o ranqueamento de respostas mais adequadas, de acordo com as políticas de proteção criadas.

— Em um sistema on-line, como a interface do ChatGPT, é possível fazer a atualização dessas barreiras. A questão com grandes modelos como o Llama, que podem ser baixados e alterados localmente, é que você tem menos flexibilidade para fazer esse controle e bloqueio — pondera o pesquisador, que testou o Llama 3.1 e obteve resultados maliciosos a partir da plataforma HuggingFace, que hospeda chats em que é possível acessar LLMs.

- Brasil já utiliza a tecnologia: ferramenta para mapear incêndios florestais chega em 15 países da Europa e África

As big techs que desenvolvem modelos de IA costumam realizar testes de vulnerabilidade de segurança com equipes internas, os chamados red teams (times vermelhos). Os profissionais simulam formas de driblar as salvaguardas dos modelos e monitoram possíveis usos indevidos das IAs, a fim de realizar bloqueios.

Na Meta, por exemplo, esse trabalho inclui a adição de filtros de segurança no desenvolvimento de ferramentas como o Llama. Mas Dora Kaufman, professora na PUC-SP e autora do livro “Desmistificando a inteligência artificial”, lembra que sempre há um grau de imprevisibilidade nesses LLMs:

— Essas falhas mostram que há um limite da própria técnica de segurança.