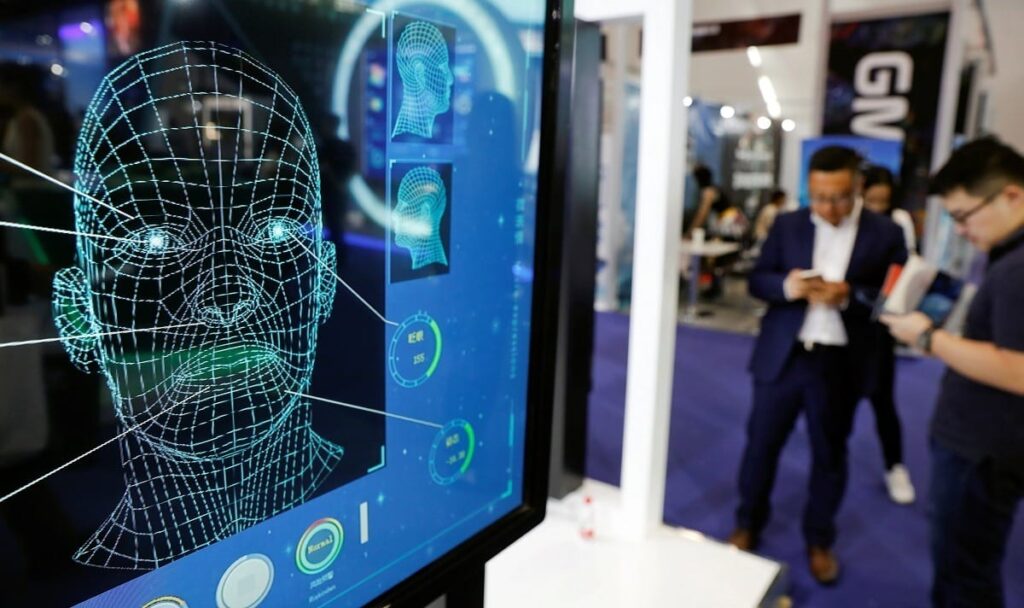

Conhecidos como ‘deepfakes’, a recriação de voz e aparência de qualquer pessoa com inteligência artificial estão cada vez mais realistas e perigosos. A tecnologia virou ferramenta dos golpistas, que teve aumento de 3000% do uso por criminosos pelo mundo, segundo o relatório da empresa inglesa Onfido.

Pela internet, não é difícil de achar vídeos feitos com deepfake. Tem vídeo imitando famosos falando que dão brinde para seguidores que fizerem um Pix, outra propaganda fake de um médico recomendando suplemento e muito mais.

Dario Centurione, influenciador digital, teve a voz clonada em um golpe, que induz a pessoa a clicar em um link falso para comprar uma caixa de chocolate com desconte. “A gente testa coisas, gente indica coisas, a gente não indica outras coisas. E aí isso vai confundir. Como as pessoas vão saber que não sou eu?”, afirma.

Até quem trabalha com inteligência artificial tem dificuldade para identificar o deepfake. Alessandra Montini, diretora do LABDATA da FIA Business School diz que demora para identificar. “Demorei já muitas horas, muitas horas para perceber que não era. E eu não consegui sozinha. Tive que usar uma IA altamente treinada para pegar o mínimo do detalhe da voz, do timbre, para poder detectar o Barack Obama”, diz.

A diretora afirma que é preciso novas maneiras de indicar o deepfake. “Deveria ter na internet um selo de segurança. Se passasse pelo seu segurança, homologado, caso contrário, pode ser um problema”, pontua.